A execução de modelos de inteligência artificial (IA) está se tornando um verdadeiro “jogo de memória”, com a gestão eficiente de chips de memória se tornando um dos principais desafios para empresas que operam IA em grande escala, segundo análise publicada pelo TechCrunch.

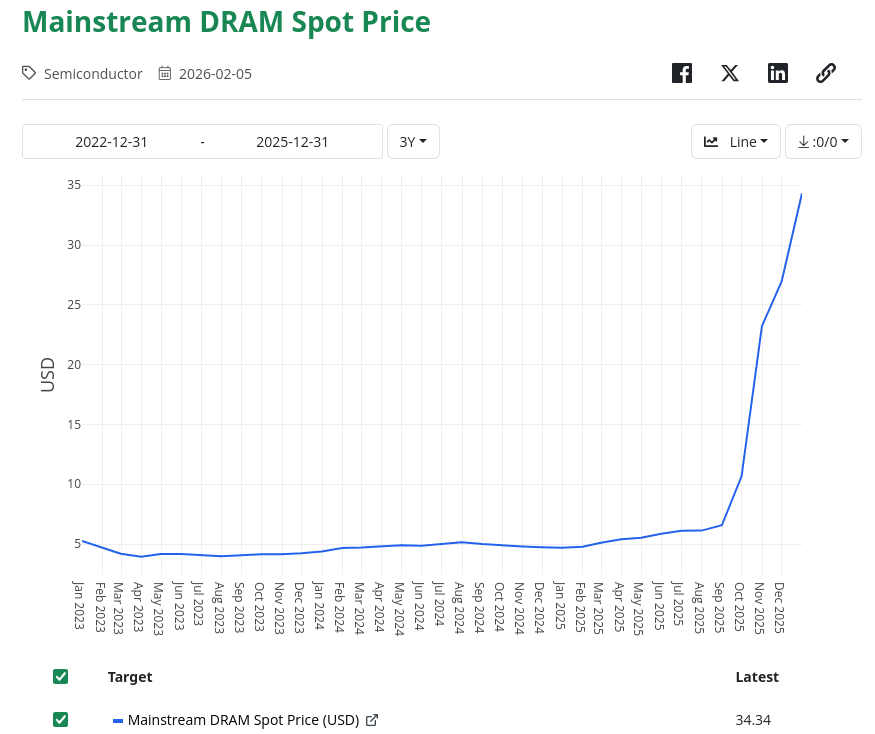

Tradicionalmente, quando se fala em infraestrutura de IA o foco recai sobre as GPUs da Nvidia; no entanto, especialistas apontam que a memória DRAM — essencial para o processamento e armazenamento temporário de dados durante a execução de modelos — está ganhando importância estratégica. A alta recente nos preços desse tipo de chip, que subiu aproximadamente 7 vezes no último ano, está impactando diretamente os custos operacionais de empresas que oferecem serviços de IA.

Memória como fator de competitividade

A discussão envolve não apenas o custo dos componentes, mas também a orquestração eficiente da memória, ou seja, a habilidade de organizar e entregar os dados corretos aos “agentes” de IA no momento certo. Segundo especialistas consultados, essa gestão é fundamental para melhorar o desempenho dos modelos com menos tokens, reduzindo o custo de inferência e melhorando a eficiência geral dos sistemas.

Analistas como Val Bercovici, executivo de IA, destacam que empresas que dominarem esse tipo de otimização poderão se destacar no mercado. A estratégia envolve decisões técnicas como uso de cache e escolha entre diferentes tipos de memória, como DRAM versus HBM, dependendo do perfil de uso e dos requisitos de desempenho.

Cache e economia de tokens

Uma das técnicas discutidas na análise é o uso de cache de prompt, que permite manter certas informações em memória por períodos definidos — como janelas de 5 minutos ou até uma hora. Buscar dados diretamente no cache sai muito mais barato do que requeri-los novamente ao modelo, sendo uma forma eficaz de reduzir os custos de execução e melhorar a velocidade de resposta. (TechCrunch)

No futuro, segundo os especialistas, os avanços nessa “gerência de memória” podem reduzir ainda mais o custo de operação de modelos de IA, tornando aplicações hoje consideradas caras mais acessíveis e viáveis economicamente.

📌 Fonte: TechCrunch